|

SEO扫盲课之如何正确设置robots.txt协议文件

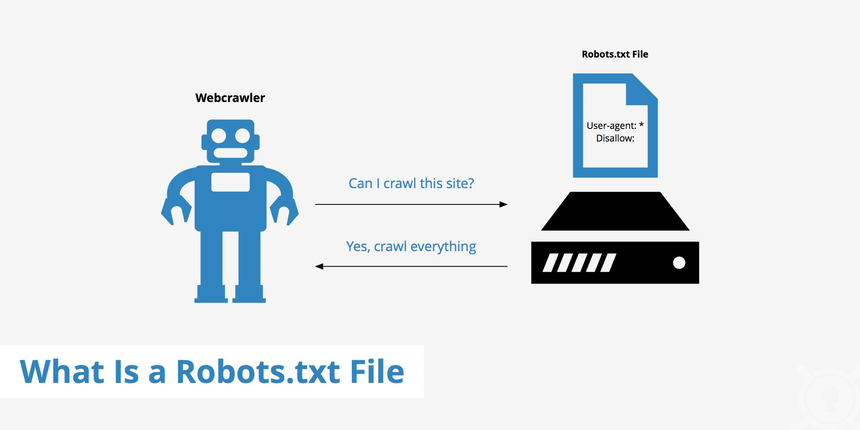

有时候站长不想抓取某些页面,比如付费内容,测试网站等等。为了保证页面不被抓取,需要使用robots文件。那怎样正确设置呢? 一般来说,当搜索引擎蜘蛛访问网站时,首先要检查网站根目录下是否有robots.txt的纯文本文件。 robots.txt文件是什么? 用于指令搜索引擎禁止抓取网站的某些内容或指定抓取网站的某些内容。 robots.txt文件只有在禁止捕获某些内容时才有意义。没有robots.txt或空文件意味着允许捕获网站上的所有内容。 注:一些由于服务器设置的问题,当robots.txt文件不存在时,它们会返回状态码200,而非404状态码。因此,搜索引擎可能会错误地解读robots文件。所以,为了避免这种情况的发生,即使你允许抓取网站上的所有内容,也要在网站根目录中放置一个空的robots.txt文件。 robots.txt文件对网站有什么好处? 增加网站权重和访问量。 阻止某些文件被搜索引擎索引,可以节省服务器带宽和网站访问速度。 为搜索引擎提供简洁的索引环境。 robots.txt基本语法 User-agent:指定的规则适合哪种蜘蛛(例如:百度Baiduspider、谷歌Googlebot或其他搜索引擎) Allow:允许抓取哪些URL路径。 Disallow:不允许抓取任何URL路径。 通配符*代表所有搜索引擎。 注:允许或禁止的目录或文件必须分开写,每一行。 实例分析。 (1)禁止所有搜索引擎抓取任何网页。 User-agent:* Disallow:/ (2)允许所有搜索引擎访问网站的任何部分。 User-agent:* Disallow: (3)仅禁止谷歌访问您的网站。 User-agent:谷歌。 Disallow:/ (4)只允许谷歌访问你的网站。 User-agent:谷歌。 Disallow: (5)禁止spider访问特定目录。 User-agent:* Disallow:/a/ Disallow:/b/ (6)允许访问特定目录中的一些url:例如:在/a/目录目录下的其他目录和文件,但是可以抓取/b/目录下的内容。 User-agent:* Disallow:/a/ Allow:/a/b/ (7)禁止访问站点中的所有动态页面。 User-agent:* Disallow:/** 怎样查看网站robots文件? 站点域名/robots.txt 比如www.zhoujiangshou.com/robots.txt。 |